Inceptionism: Going Deeper into Neural Networks

Posted: Wednesday, June 17, 2015

Share on Twitter Share on Facebook

Posted by Alexander Mordvintsev, Software Engineer, Christopher Olah, Software Engineering Intern and Mike Tyka, Software Engineer

Update - 13/07/2015

Images in this blog post are licensed by Google Inc. under a Creative Commons Attribution 4.0 International License. However, images based on places by MIT Computer Science and AI Laboratory require additional permissions from MIT for use.

Artificial Neural Networks have spurred remarkable recent progress in image classification and speech recognition. But even though these are very useful tools based on well-known mathematical methods, we actually understand surprisingly little of why certain models work and others don’t. So let’s take a look at some simple techniques for peeking inside these networks.

We train an artificial neural network by showing it millions of training examples and gradually adjusting the network parameters until it gives the classifications we want. The network typically consists of 10-30 stacked layers of artificial neurons. Each image is fed into the input layer, which then talks to the next layer, until eventually the “output” layer is reached. The network’s “answer” comes from this final output layer.

One of the challenges of neural networks is understanding what exactly goes on at each layer. We know that after training, each layer progressively extracts higher and higher-level features of the image, until the final layer essentially makes a decision on what the image shows. For example, the first layer maybe looks for edges or corners. Intermediate layers interpret the basic features to look for overall shapes or components, like a door or a leaf. The final few layers assemble those into complete interpretations—these neurons activate in response to very complex things such as entire buildings or trees.

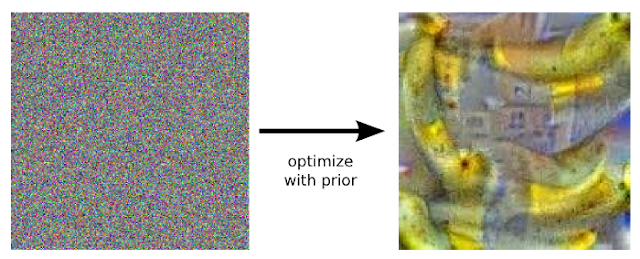

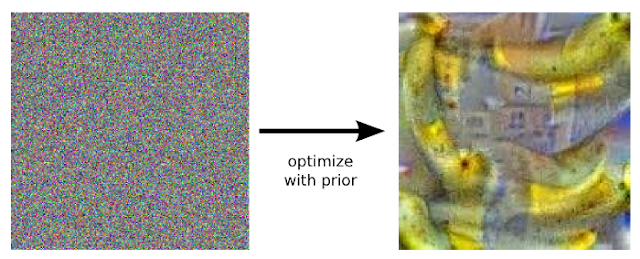

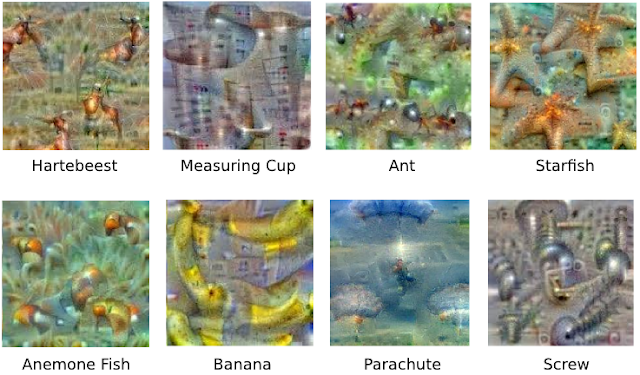

One way to visualize what goes on is to turn the network upside down and ask it to enhance an input image in such a way as to elicit a particular interpretation. Say you want to know what sort of image would result in “Banana.” Start with an image full of random noise, then gradually tweak the image towards what the neural net considers a banana (see related work in [1], [2], [3], [4]). By itself, that doesn’t work very well, but it does if we impose a prior constraint that the image should have similar statistics to natural images, such as neighboring pixels needing to be correlated.

+++++++++++++++++++++++++++++ (Машинный перевод)

Inceptionism: углубляясь в нейронных сетях

Добавлено: Среду, 17 июня 2015 Поделиться на Twitter Поделиться через Фейсбук

Сообщение от Александра Мордвинцев, инженер-программист, Кристофер Ола, Software Engineering междунар и Майк тыка, инженер-программист

обновления - 13/07/2015

Изображения в этом блоге лицензированы Google Inc. под Creative Commons Attribution 4.0 License Международного . Тем не менее, изображения, основанные на местах по MIT компьютерных наук и А. И. лаборатории требует дополнительных разрешений от MIT для использования.

Искусственные нейронные сети побудили замечательный недавний прогресс в классификации изображений и распознавания речи . Но даже если это очень полезные инструменты, основанные на известных математических методов, мы на самом деле понять, на удивление мало, почему некоторые модели работают, а другие нет. Итак, давайте взглянем на некоторые простые методы для выглядывает внутри этих сетей.

Мы обучаем искусственной нейронной сети, показывая ему миллионы обучающих примеров и постепенно регулируя параметры сети пока не дает классификаций, которые мы хотим. Сеть обычно состоит из 10-30 уложенных слоев искусственных нейронов. Каждое изображение подается во входной слой, который затем отвечает на следующий уровень, до тех пор, пока не будет достигнута в конечном итоге слой "Выход". "Ответ" Сеть приходит от этой последней выходного слоя.

Одна из проблем нейронных сетей является понимание, что именно происходит на каждом слое. Мы знаем, что после тренировки, каждый слой постепенно извлекает все более и более высокого уровня особенности изображения, пока последний слой по существу не принимает решение о том, что изображение показывает. Например, первый слой может быть, ищет краев или углов. Промежуточные слои интерпретировать основные черты искать общие формы или компонентов, как дверь или листа. Последние несколько слоев собрать тех, в полных интерпретаций-эти нейроны активируют в ответ на очень сложные вещи, такие как целые здания или деревья.

Один из способов визуализировать то, что идет на это, чтобы включить сеть с ног на голову и спросить его для повышения входного изображения в таких образом, чтобы вызвать определенную интерпретацию. Скажем, вы хотите знать, какие изображения бы привести к "Банана". Начните с изображением полной случайного шума, а затем постепенно настроить изображение к, что нейронная сеть считает банан (см соответствующую работу в [1] , [2] , [3] , [4] ). Сам по себе, что не очень хорошо работает, но это, если мы наложим предварительное ограничение, что изображение должно иметь подобную статистику на природные изображений, таких как соседних пикселей, нуждающихся в коррелировать.

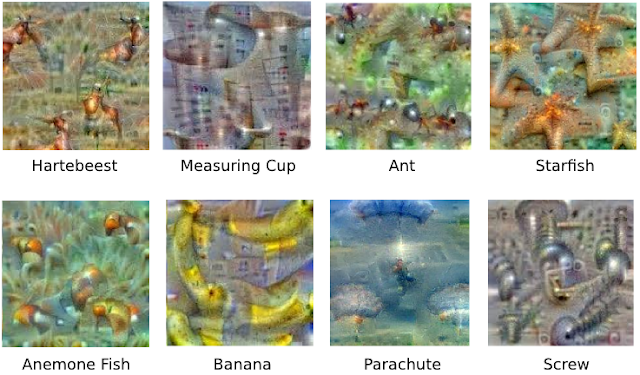

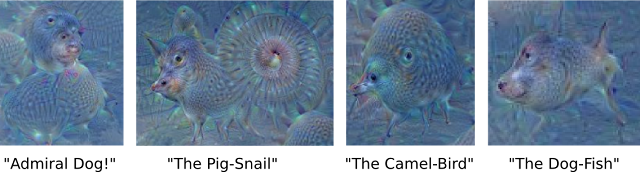

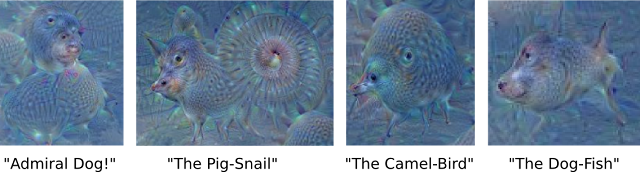

So here’s one surprise: neural networks that were trained to discriminate between different kinds of images have quite a bit of the information needed to generate images too. Check out some more examples across different classes

+++++++++++++++++++++++++++++

Так вот один сюрприз: нейронные сети, которые были обучены распознавать различные виды изображений есть совсем немного информации, необходимой для генерации изображения тоже. Проверьте еще несколько примеров по всей различных классов:

Why is this important? Well, we train networks by simply showing them many examples of what we want them to learn, hoping they extract the essence of the matter at hand (e.g., a fork needs a handle and 2-4 tines), and learn to ignore what doesn’t matter (a fork can be any shape, size, color or orientation). But how do you check that the network has correctly learned the right features? It can help to visualize the network’s representation of a fork.

Indeed, in some cases, this reveals that the neural net isn’t quite looking for the thing we thought it was. For example, here’s what one neural net we designed thought dumbbells looked like:

++++++++++++++++++++++++++++++++

Почему это важно? Ну, мы обучаем сети, просто показывая им много примеров того, что мы хотим, чтобы узнать, надеясь, что они извлечь суть вопроса на стороны (например, вилка нужна ручка и 2-4 зубцов), и научиться игнорировать то, что Безразлично 'т вещества (вилка может быть любой формы, размера, цвета или ориентация). Но как вы убедитесь, что сеть правильно извлекли правильные черты? Это может помочь визуализировать представление сети в вилки.

В самом деле, в некоторых случаях, это показывает, что нейронная сеть не совсем ищет то, что мы думали, что это было. Например, вот то, что один нейронная сеть мы проектировали мысль гантели выглядел:

There are dumbbells in there alright, but it seems no picture of a dumbbell is complete without a muscular weightlifter there to lift them. In this case, the network failed to completely distill the essence of a dumbbell. Maybe it’s never been shown a dumbbell without an arm holding it. Visualization can help us correct these kinds of training mishaps.

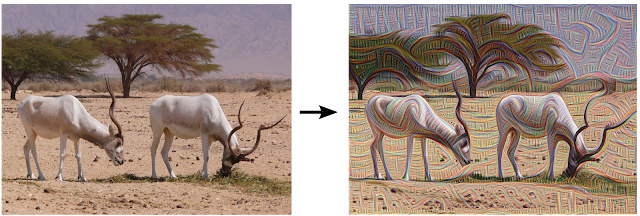

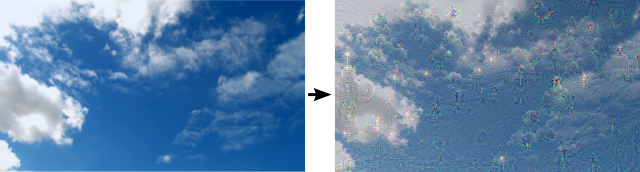

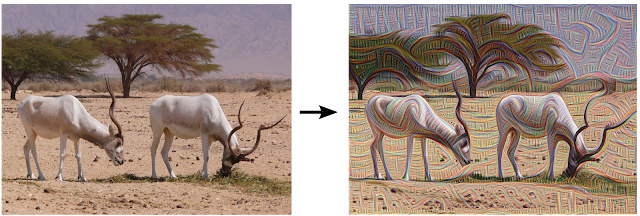

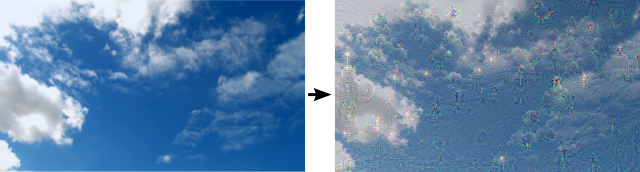

Instead of exactly prescribing which feature we want the network to amplify, we can also let the network make that decision. In this case we simply feed the network an arbitrary image or photo and let the network analyze the picture. We then pick a layer and ask the network to enhance whatever it detected. Each layer of the network deals with features at a different level of abstraction, so the complexity of features we generate depends on which layer we choose to enhance. For example, lower layers tend to produce strokes or simple ornament-like patterns, because those layers are sensitive to basic features such as edges and their orientations.

+++++++++++++++++++++++++++++++++++

Есть гантели в порядке там, но это, кажется, не картина гантели не обходится без мышечной тяжелоатлет есть поднять их. В этом случае сеть не удалось полностью перегонки сущность гантели. Может быть, это никогда не было показано, гантели, без кронштейна его проведения. Визуализация может помочь нам исправить эти виды учебных неудач.

Вместо того, чтобы точно прописи, которые оснащены мы хотим, чтобы усилить сеть, мы также можем позволить сеть принять это решение. В этом случае мы просто накормить сети произвольное изображение или фотографию, и пусть сети проанализировать картину. Мы затем выбрать слой и попросить сети для повышения все, что обнаружено. Каждый слой сети сделок с особенностями на другом уровне абстракции, так сложности функций мы генерируем зависит от того, какой слой мы выбираем для повышения. Например, нижние слои имеют тенденцию производить удары или простые украшения, как модели, так как эти слои чувствительны к основных функций, таких как краев и их ориентации.

Left: Original photo by Zachi Evenor. Right: processed by Günther Noack, Software Engineer

++++++++++++++++++++++++++++++

Слева: Оригинальная фотография с Zachi Evenor . Справа: обрабатываются Гюнтер Noack, инженер-программист

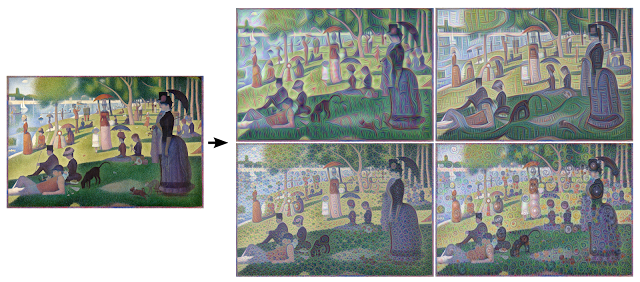

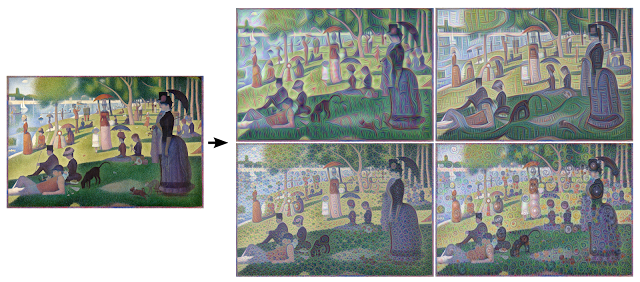

Left: Original painting by Georges Seurat. Right: processed images by Matthew McNaughton, Software Engineer

If we choose higher-level layers, which identify more sophisticated features in images, complex features or even whole objects tend to emerge. Again, we just start with an existing image and give it to our neural net. We ask the network: “Whatever you see there, I want more of it!” This creates a feedback loop: if a cloud looks a little bit like a bird, the network will make it look more like a bird. This in turn will make the network recognize the bird even more strongly on the next pass and so forth, until a highly detailed bird appears, seemingly out of nowhere.

+++++++++++++++++++++++++++++++++

Слева: Оригинальный живопись G eorges Сера . Справа: обрабатываются изображения Мэтью McNaughton, инженер-программист

Если мы выбираем слои высшего уровня, которые определяют более сложные функции в образах, сложные функции или даже целые объекты, как правило, возникают. Опять же, мы просто начать с существующего образа и дать его в наш нейронной сети. Мы просим сеть: "что вы видите там, я хочу больше об этом!" Это создает петлю обратной связи: если облака выглядит немного как птица, сеть будет сделать его более похожим на птицу. Это, в свою очередь, сделает сеть признать птицу еще сильнее на следующем проходе и так далее, до тех пор, пока не появится очень подробный птица, казалось бы, из ниоткуда.

The results are intriguing—even a relatively simple neural network can be used to over-interpret an image, just like as children we enjoyed watching clouds and interpreting the random shapes. This network was trained mostly on images of animals, so naturally it tends to interpret shapes as animals. But because the data is stored at such a high abstraction, the results are an interesting remix of these learned features.

++++++++++++++++++++++++++++++++++

Результаты интригующим, даже относительно простой нейронной сети могут быть использованы для более интерпретировать изображение, так же, как в детстве мы с удовольствием наблюдал облака и интерпретации случайных форм. Эта сеть была обучена в основном на изображениях животных, поэтому, естественно, он стремится интерпретировать формы, как животных. Но поскольку данные хранятся на таком высоком абстракции, результаты интересны ремикс этих ученых функций.

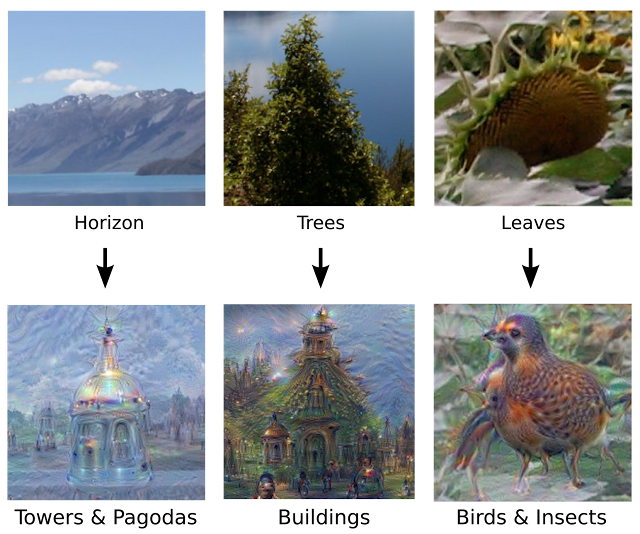

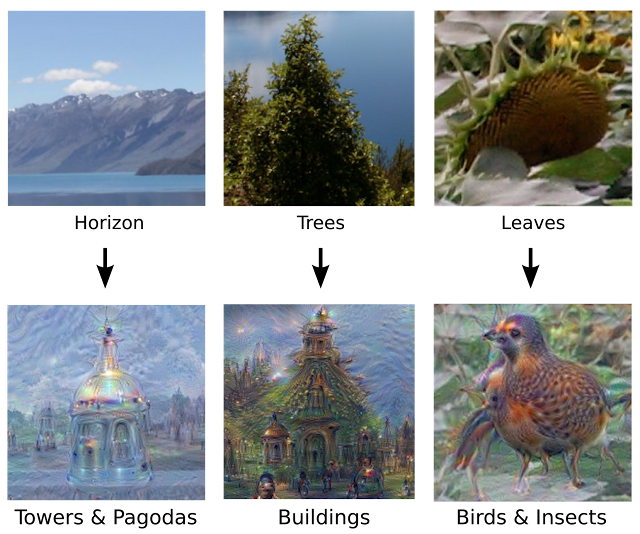

Of course, we can do more than cloud watching with this technique. We can apply it to any kind of image. The results vary quite a bit with the kind of image, because the features that are entered bias the network towards certain interpretations. For example, horizon lines tend to get filled with towers and pagodas. Rocks and trees turn into buildings. Birds and insects appear in images of leaves.

+++++++++++++++++++++++++++++++++

Конечно, мы можем сделать больше, чем облака, наблюдая с этой техникой. Мы можем применить его к любой части изображения. Результаты могут отличаться немного с рода изображения, поскольку функции, которые вводятся смещении сети к определенным интерпретациям. Например, линии горизонта, как правило, заполняются с башнями и пагодами. Скалы и деревья превращаются в зданиях. Птицы и насекомые появляются в образах листьев.

The original image influences what kind of objects form in the processed image.

This technique gives us a qualitative sense of the level of abstraction that a particular layer has achieved in its understanding of images. We call this technique “Inceptionism” in reference to the neural net architecture used. See our Inceptionism gallery for more pairs of images and their processed results, plus some cool video animations.

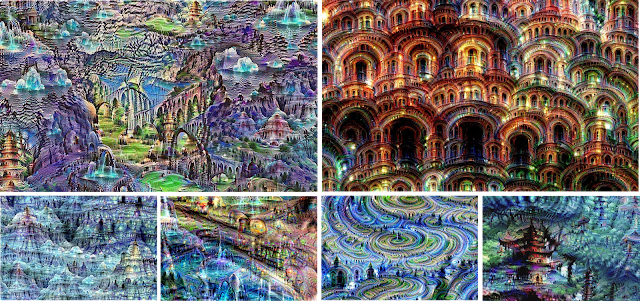

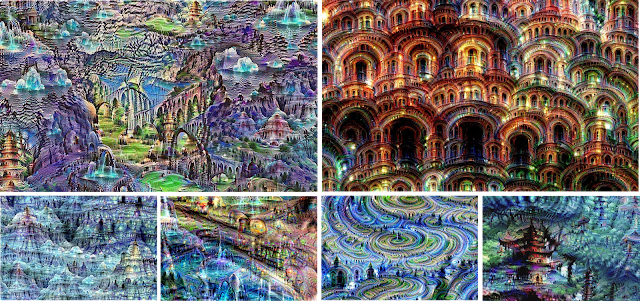

We must go deeper: Iterations

If we apply the algorithm iteratively on its own outputs and apply some zooming after each iteration, we get an endless stream of new impressions, exploring the set of things the network knows about. We can even start this process from a random-noise image, so that the result becomes purely the result of the neural network, as seen in the following images:

+++++++++++++++++++++++++++++++++++

Оригинальные влияет на имидж Какие объекты образуют в обработанном изображении.

Эта техника дает нам качественный смысл уровне абстракции, что особенно слой, достигнутого в его понимании образов. Мы называем эту технику "Inceptionism" со ссылкой на нейронной сети архитектуры используется. Смотрите наш Inceptionism галереи . для нескольких пар изображений и их результатов обработки, плюс некоторые интересные анимации видео

Мы должны глубже: итераций

Если мы применим алгоритм итеративно на своих выходах и применить некоторые масштабирования после каждой итерации, мы получим бесконечный поток новые впечатления, исследуя множество вещей сеть знает. Мы можем даже начать этот процесс с произвольного шума изображения, так что результат становится чисто результат нейронной сети, как показано на следующих рисунках:

Neural net “dreams”— generated purely from random noise, using a network trained on places by MIT Computer Science and AI Laboratory. See our Inceptionism gallery for hi-res versions of the images above and more (Images marked “Places205-GoogLeNet” were made using this network).

The techniques presented here help us understand and visualize how neural networks are able to carry out difficult classification tasks, improve network architecture, and check what the network has learned during training. It also makes us wonder whether neural networks could become a tool for artists—a new way to remix visual concepts—or perhaps even shed a little light on the roots of the creative process in general.

+++++++++++++++++++++++++++++

Нейронной сети "мечты" - генерируется чисто случайного шума от, используя сеть обученных на местах по MIT компьютерных наук и А. И. лаборатории . Смотрите наш Inceptionism галереи для привет разрешением версии указанных изображений и более (Картинки с пометкой "Places205-GoogLeNet" были сделаны с помощью этой сети).

Методы, представленные здесь, поможет нам понять и представить, как нейронные сети способны выполнять сложные задачи классификационных улучшить сетевую архитектуру, и проверить, что сеть, полученные в ходе обучения. Он также заставляет нас задаться вопросом, может ли нейронные сети становятся инструментом для художников-новому ремикс визуальные концепции, или, возможно, даже пролить немного света на корни творческого процесса в целом.

http://googleresearch.blogspot.co.uk/20 … eural.html